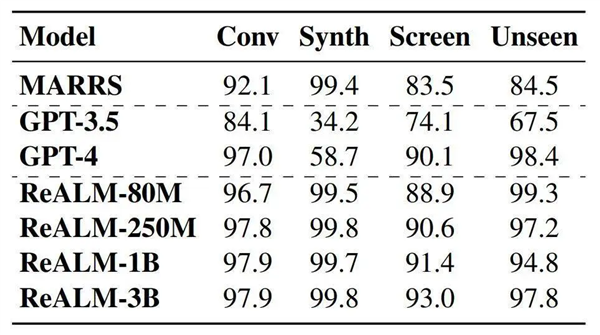

4月2日消息,据媒体报道,在最近的一篇论文中,苹果的研究团队宣称,他们提出了一个可以在设备端运行的模型ReALM,这个模型在某些方面可以超过GPT-4。

ReALM的参数量分别为80M、250M、1B和3B,体积都非常小,适合在手机、平板电脑等设备端运行。

ReALM研究的主要是,让AI识别文本中提到的各种实体(如人名、地点、组织等)之间的指代关系的过程。

论文将实体分为三种:

屏幕实体(On-screen Entities):指的是当前显示在用户屏幕上的内容。

对话实体(Conversational Entities):指的是与对话相关的内容。例如,用户说“打电话给妈妈”,那么妈妈的联系人信息就是对话实体。

后台实体(Background Entities):指的是与用户当下操作或屏幕显示内容可能并不直接相关的实体,比如正在播放的音乐或即将响起的闹铃。

论文表示,尽管大型语言模型已经证明在多种任务上具有极强的能力,但在用于解决非对话实体(如屏幕实体、后台实体)的指代问题时,它们的潜力还没有得到充分利用。

而ReALM则是一种全新的方法,通过将其性能与GPT-3.5和GPT-4进行了对比,显示最小模型的性能与GPT-4相当,而更大的模型则显著超过了GPT-4。

这项研究有望用来改进苹果设备上的Siri助手,帮助Siri更好地理解和处理用户询问中的上下文。